壹 前言

隨著5G網路及AI人工智慧的發展,沉浸式(Immersive)科技結合VR虛擬實境的應用也日益蓬勃,顛覆了以往人們觀看影片的傳統思維。在沉浸式的應用裡,人們可搭配頭戴式裝置(Head Mounted Device, HMD),自由選擇觀看視角,感受到360度環場互動的虛擬體驗。然而,要提供高畫質360度影音服務需要耗費大量的網路頻寬,並且終端設備也需進行大量的解碼工作,勢必增加端對端時延(end-to-end latency),也容易讓用戶產生暈眩及不適感。如何在維持良好的使用者體驗下,有效地降低傳輸頻寬及終端設備的運算工作,提供虛擬實境的高品質360度全景影像串流服務是中華電信研究院現正投入研究的議題之一。

貳 科技發展現況

一、 360度全景影像串流技術簡介

近年來,隨著VR虛擬實境的應用快速崛起,所具有的沉浸式、互動式、可創作的應用不斷地推陳出新,可涉及教育、商業、娛樂、醫學、航空…等各種不同領域,相關產業年成長率達13.8%,於2030年全球預測產值更高達 870 億美元[1]。其中VR 360度影音娛樂更是VR領域中一項重要應用,不僅提供使用者身歷其境的感受,也向使用者呈現真實且震撼的沉浸式體驗。

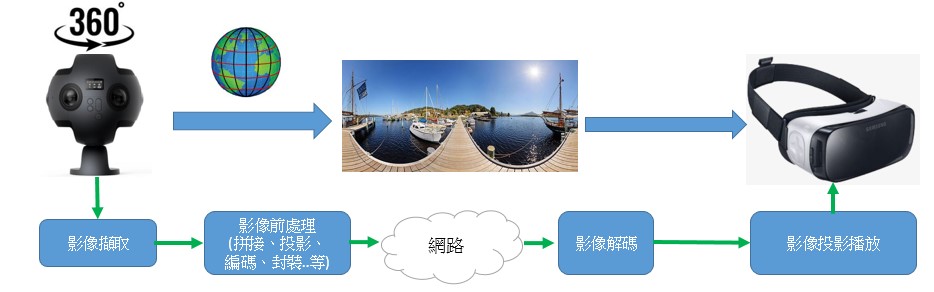

圖一為360度全景影像串流的流程圖,360度全景影像會由多台攝影機在不同角度進行環場的影像拍攝再拼接而成,經由平面化投影技術將全景影像轉換成2D平面影像,接著進行編碼成串流輸出;接收端收到串流內容後會進行解碼,依據使用者面向角度,呈現相對應視角內容至終端設備上。

市面上有許多機構在進行360度全景影像串流的VR技術研究,以期將360全景影像串流技術擴展至商業市場等各種領域,MPEG组織(Moving Picture Experts Group)在2015年上提出OMAF(Omnidirectional Media Application Format,全景影像的應用格式)標準[2],製定了一系列全景影像格式以及傳輸機制,讓各種VR終端皆可依據OMAF標準來進行儲存、轉換、傳輸及呈現。因此,OMAF也是首個在虛擬實境中,針對全景影像來定義內容儲存及串流格式的標準規格。

目前業界在傳輸360度全景影像串流內容時,多採用了[全視角傳輸方法],如圖一所示,該方法是將全部360度的全景影像傳送到使用者終端,終端將全部視角的內容解碼後,依據當前視角,呈現相對應的影像內容。此方法的優點是MTP(Motion To Photon,使用者移動視角到顯示器呈現影像的時間延遲)延遲低;當使用者轉換視角,可立即切換成當前視角的影片畫面,但缺點是易造成網路頻寬及終端運算資源的浪費,因需花費大量頻寬及運算量在沒有被播放的影像。

為了解決浪費的議題,OMAF提出了[360度視角串流播放方法],來降低資料的遞送量。所謂的360度視角串流播放方法,就是影音伺服器僅傳輸使用者正在觀看的視角內容,其運作原理如下:

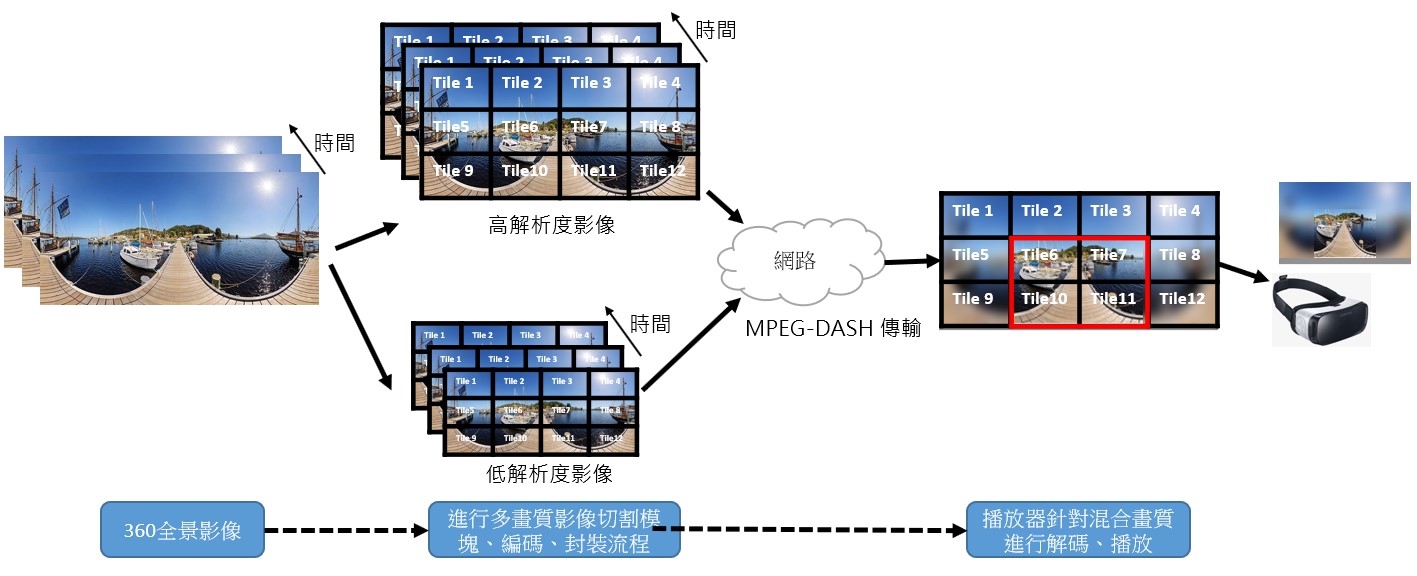

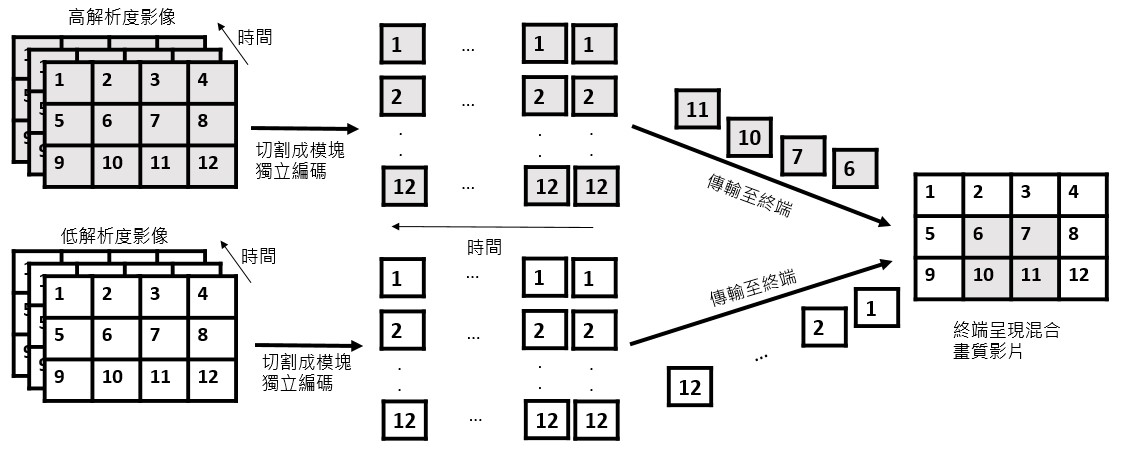

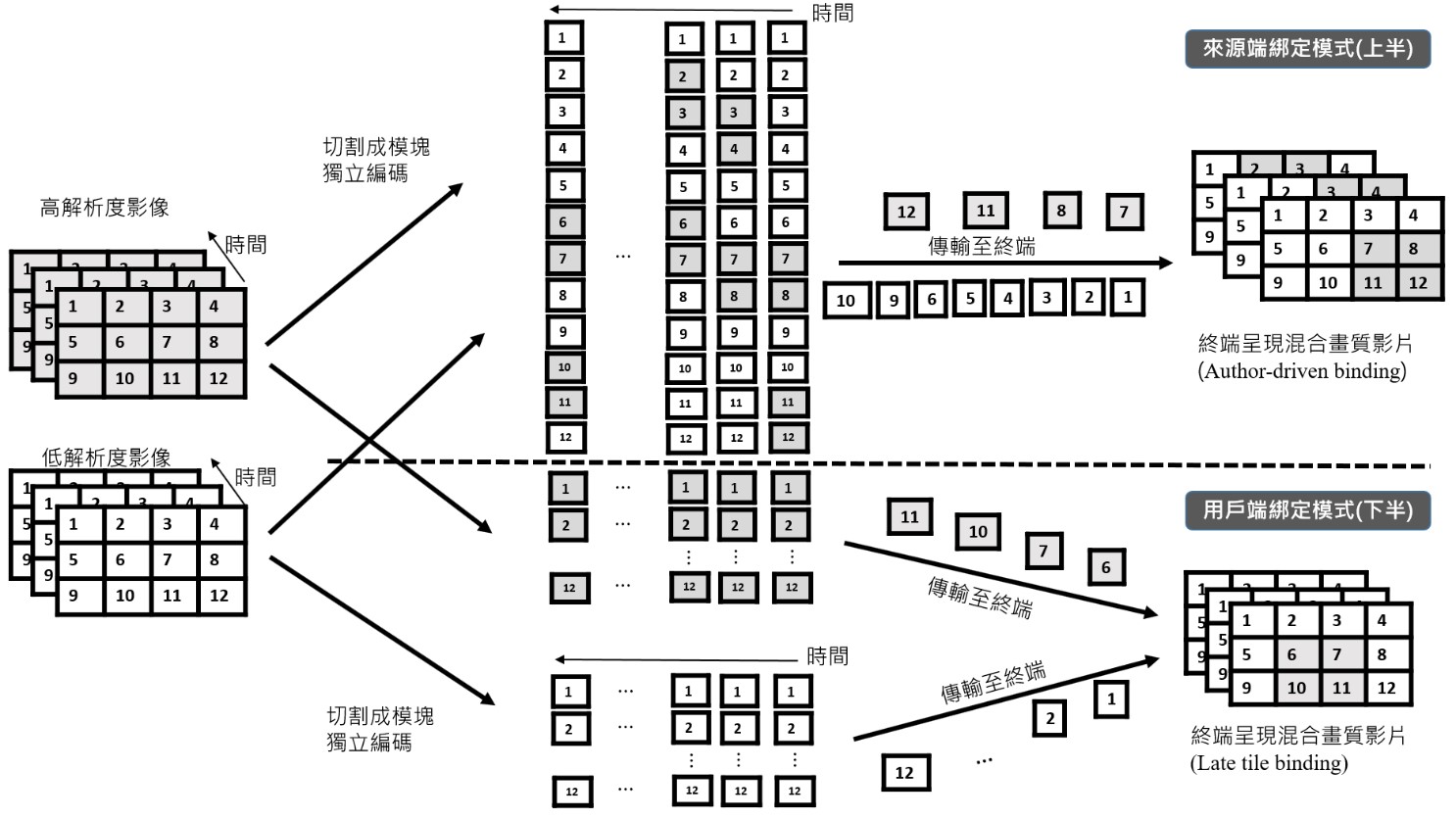

因考量到使用者透過終端設備觀看全景影像時,往往視線範圍只會落在全景影像中的一小部份區域,基於這個特性,OMAF定義出了可模塊(tile-based)編碼的規範,如圖二所示;全景影像切割成多個可獨立編碼成多種解析度的模塊,依據使用者觀看行為,動態調整欲傳送的合適模塊。在視角範圍內(如圖二紅框所示)的影像以高解析度方式傳送,視角外的影像以低解析度方式傳輸,終端收到混合畫質影像後再進行解碼呈現畫面。優點是可大量減少頻寬,提升傳輸效能,缺點則是當視角變換時,會需要額外時間重新下載視角變換後所對應的高畫質影片,進而導致影像畫質會由差轉好、或畫面停頓的現象發生。

接著,我們將針對[360度視角串流播放方法]進行深度說明。

二、 360度視角串流播放方法之技術規格

MPEG組織分別在2018年與2020年完成訂定OMAF V1[3]、OMAF V2[4],主要差異在於OMAF V2將原本OMAF V1在制定全景影像格式中所定義的三自由度(Three Degrees of Freedom,3DOF)提升到六自由度(Six Degrees of Freedom,6DOF),讓使用者可透過體感、視線、手勢、觸控等方式來選取任何位置的觀看視角,影音伺服器也能精確地擷取到使用者更精細的動作,進而提供使用者更佳的虛擬實境感受。

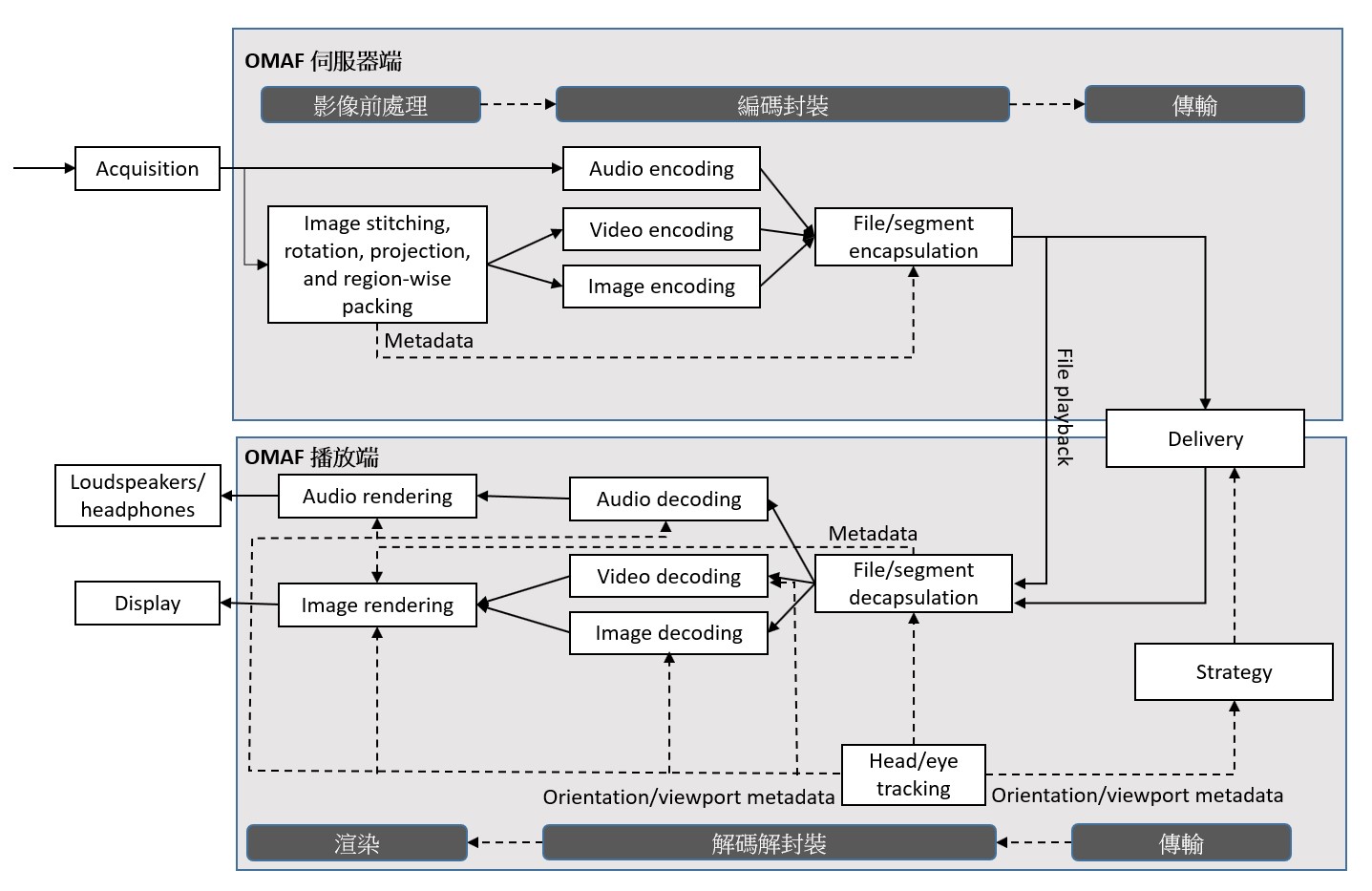

圖三為OMAF規範在傳輸全景影像的流程圖,主要分成兩大部份來詳細說明:

(一) 伺服器端

伺服器端的流程主要包含影像前處理、編碼封裝、傳輸等項目,全景影像可透過多台相機在360度不同方位進行同步環景拍攝,所擷取的聲音會直接編碼成AAC或3D MPEG-H[5]編碼流,影像則會再進行影像前處理。

在影像前處理中,會將多台相機拍攝畫面視需求進行旋轉、縫合程序成全景影像,再透過投影方式,將全景影像轉成二維平面後進行編碼。目前投影有兩種主流的格式:1. 等距柱狀投影(Equirectangular projection)。2. 立方體貼圖投影(Cubemap projection)。

因考量到使用者在觀看全景影像時,受限於觀看視角,只會觀賞到全景影像的局部畫面,若以整個全景影像進行編碼,易讓使用者在有限頻寬下,無法看到高品質的畫面。因此,OMAF定義的可模塊(tile-based)編碼法,可根據移動限制模塊組(motion-constrained tile sets,MCTS)的編碼方法,將全景影像中分割成數個不重疊的模塊,每個模塊可獨立編碼成不同解析度、不同位元率的模塊編碼流。如圖四所示,全景影像分割成3x4的矩陣,其中包括3列4行共12個模塊進行模塊編碼,再個別編碼出不同畫質的編碼流。然後將編碼後的影音流,依據ISOBMFF(ISO Base Media File Format)標準[6]進行檔案儲存及封裝成數個影音片段(Segment),再透過MPEG-DASH(Dynamic Adaptive Streaming over HTTP)或MMT(MPEG Media Transport)協定傳輸至OMAF 播放端。

(二) 播放端

為了讓使用者有良好的收視體驗,伺服器端會參考使用者的當前視角,在視角範圍內以高畫質模塊來呈現,視角範圍外以低畫質模塊來呈現。因此,在高低畫質模塊選擇上,如圖五所示,OMAF標準提出了兩種方法:

1. 來源端綁定(Author-driven binding):由來源端主導觀看視角 來源端提供多個觀看情境讓使用者選擇,使用者可從中選擇一個合適的情境收看,伺服器端再依所選情境的觀看軌跡,將對應的高低畫質模塊影音片段傳送到播放端。

2. 用戶端綁定(Late tile binding):依使用者轉頭行為決定觀看視角 由使用者自行選擇觀看的視角,在收看同時,可利用頭部/眼睛追蹤模組即時取得目前使用者視角,依據使用者的觀看視角及網路頻寬來動態選擇合適畫質及位元率的模塊,向伺服器端取得對應的影音片段。

播放器接收到影音後,會進行解封裝,再將影像編碼流、聲音編碼流送到相對應的解碼器進行解碼,解碼後的影像模塊會渲染(Render)成全景畫面,再投影輸出至VR終端設備顯示,聲音則輸出至揚聲器。

三、 360度視角串流播放方法之品質量測

在確保能提供良好的使用者體驗,通常會以MTP延遲視為評斷的標準。MTP延遲愈短,使用者在VR設備的沉浸感體驗愈好,MTP延遲愈長,使用者在VR設備的不適感/暈眩感可能將會更為強烈。因此,在觀看全景影像時,一旦使用者轉移視角,使用者會在短時間內先看到低品質畫面,隨後再切換成高品質畫面,但倘若切換時間過久,使用者則可能會移轉到其他視角、甚至放棄收看,將嚴重影響使用者的收視體驗。

視角預測是一個能有效減少MTP延遲的做法,因使用者在觀看全景影像並移動視角的同時,終端需先取得使用者當前視角後,再由伺服器端下載對應的影音模塊播放。然而,每次下載皆需要經過請求、下載、解碼、播放等程序,這些程序皆需要額外的處理時間,進而增加MTP延遲。若能結合視角預測,高機率預測出使用者視角的移動,預先下載可能會播放的影音模塊並存入終端緩衝區內,後續當使用者切換到該視角時,終端設備就可直接存取緩衝內容,以減少MTP延遲、確保觀看品質。

目前有數種視角預測方式被提出,如較簡單的固定公式預測法[7]、與結合機器學習的AI(Artificial Intelligence)預測法如追蹤(TRACK)預測法[8],軌道(Trajectory)預測法[9]等。依據各預測法的數據顯示,準確性高的預測法的確可減少MTP延遲,但針對不同類型的影片內容,也會明顯地影響預測的準確性,因此在選擇預測法上必須額外注意。

四、 360度視角串流播放方法之技術現況

目前已有多家國際大廠投入全景影像傳輸技術,包含Intel、Nokia等公司,以下列舉幾家較代表性進行說明:

(一) Intel公司之Immersive-Video-Sample[10]

Immersive-Video-Sample是Intel OpenVisualCloud針對360度全景影音串流技術所提供的開源軟體,在傳輸上除了遵循OMAF標準使用MPEG-DASH串流協定外,也自行實作出結合低延遲WebRTC的串流方案,表一是MPEG-DASH與WebRTC的簡單比較,其中:

- MPEG-DASH是使用HTTP/TCP可靠傳輸,可透過CDN大量佈署,但端與端延遲較高,不適用於低延遲即時服務。

- WebRTC採用UDP即時傳輸,延遲較低,可用於即時服務,但因需針對每一連線進行頻寬預測,動態調整串流位元率,所需硬體資源較高,若要大量佈署,成本較高。

| MPEG-DASH | WebRTC | |

|---|---|---|

| 通訊協定 | HTTP/TCP | RTP/UDP |

| 端與端延遲 | 高 | 低 |

| 佈署方式 | CDN | Media server |

| 頻寬控制 | 適應性位元率(adaptive bitrate) | 預測可用頻寬來決定串流位元率 |

(二) Nokia公司之OMAF[11]

Nokia公司為共同制定OMAF標準的企業之一,在沉浸式影音方面有相當廣泛的研究與技術發展,並於2018年10月推出OMAF的開源軟體進行360度全景影像串流,主要使用MPEG-DASH方式進行實作,針對高低畫質模塊切換延遲進行優化。同時,Nokia公司也致力於壓縮技術上的研究,隨著新一代影音壓縮技術(VVC/H.266) 在2020年7月問世,在相同畫質下,所需要傳輸的位元率將是現有壓縮技術HEVC的50%,未來結合5G網路及新一代影音壓縮技術,提供360度全景影像串流服務將可大大縮短端對端的延遲。

參 結論

在360度全景影像串流技術中,使用[360度視角串流播放方法]的確可讓使用者在有限的網路頻寬及終端運算效能下,感受到高品質影音所帶來真實且震撼的沉浸式體驗。但減少使用者頻繁切換視角所造成的MTP延遲也是刻不容緩的重要議題,因使用者在切換視角時,會依當前視角下載合適模塊,再透過解碼、渲染的處理過程,才會投影至VR終端呈現,過程中使用者也會看到畫質由低轉高的情況,倘若等待時間過久或出現卡頓情況,會嚴重影響使用者收視體驗。要改善此問題,目前可結合視角預測方法,事先下載使用者可能會觀看的模塊,若預測正確率高,則可減少MTP延遲,緩解暈眩感,因此,如何設計出高預測率的視角預測方法也是未來持續努力的方向。

肆 參考文獻

[1] https://finance.yahoo.com/news/virtual-reality-market-reach-87-090000992.html

[2] Miska M.H Annuksela, Ye-Kui Wang,“An Overview of Omnidirectional MediA Format (OMAF)”, Proceedings of the IEEE | Vol.109, No. 9, September 2021

[3] ISO/IEC (2018). “Information technology –Coded representation of immersive media(MEPG-I) –Part2: Omnidirectional media format”, Final Draft International Standard.

[4] ISO/IEC (2020). “DIS Draft Text for 2nd Ed.Of 23090-2”, MPEG document m52943.

[5] Jürgen Herre, Johannes Hilpert, Achim Kuntz, Jan Plogsties, "MPEG-H 3D Audio—The New Standard for Coding of Immersive Spatial Audio", in IEEE Journal of Selected Topics in Signal Processing, Vol 9, Issue 5, Aug 2015

[6] Information Technology—Coding of Audio-Visual Objects—Part 12: ISO Base Media File Format, Standard ISO/IEC 14496-12, 2012.

[7] ”Intel Immersive-Video-Sample”, https://github.com/OpenVisualCloud/Immersive-Video-Sample

[8] M. F. R. Rondón, L. Sassatelli, R. Aparicio-Pardo and F. Precioso, "TRACK: A New Method From a Re-Examination of Deep Architectures for Head Motion Prediction in 360 Videos," in IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 44, no. 9, pp. 5681-5699, 1 Sept. 2022.

[9] A. Alahi et al., “Social LSTM: Human trajectory prediction in crowded spaces,”in Proc. Conf. Comput. Vision Pattern Recognit., 2016, pp. 961-971.

[10] OpenVisualCloud /Immersive-Video-Sample, http://github.com/OpenVisualCloud/Immersive-Video-Sample

[11] nokiatech /omaf, https://github.com/nokiatech/omaf